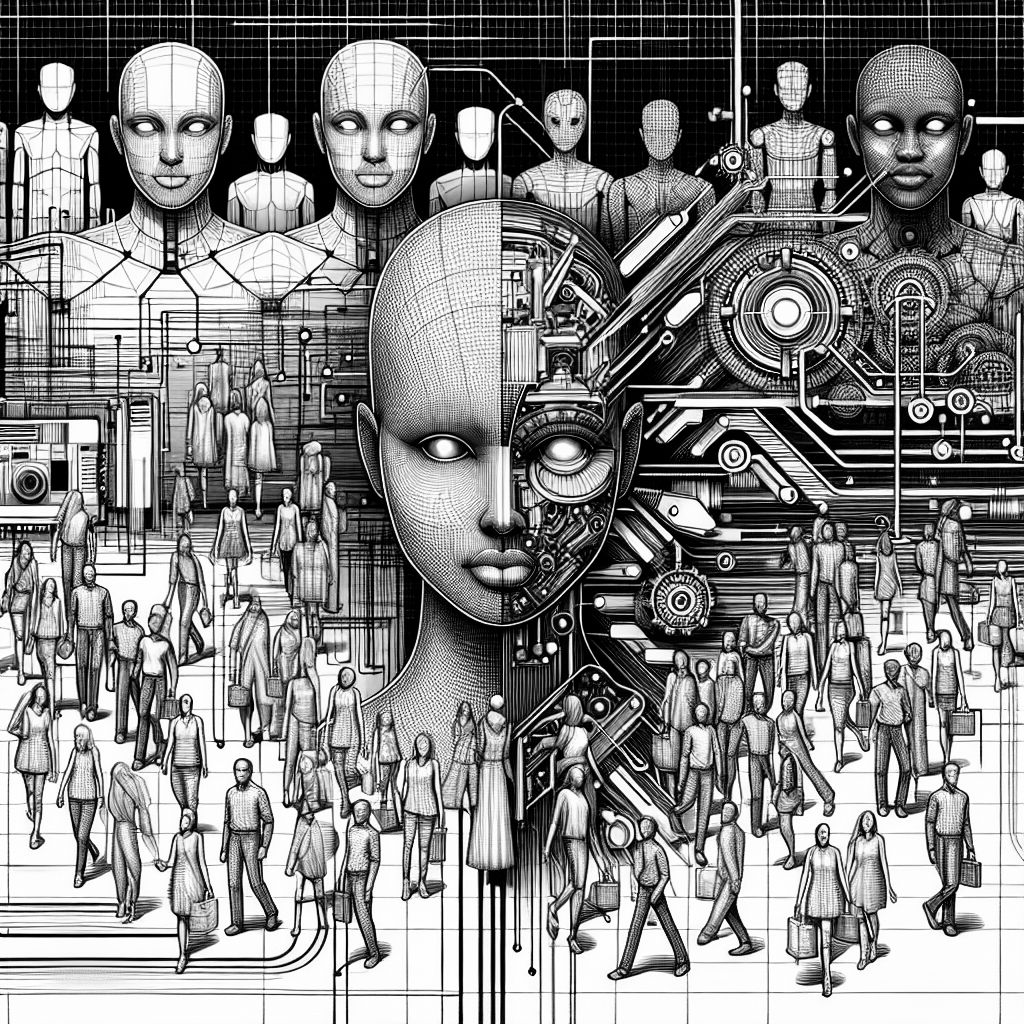

MÜNCHEN (IT BOLTWISE) – Die Entwicklung von Künstlicher Intelligenz schreitet unaufhaltsam voran, doch mit ihr kommen auch neue Herausforderungen, insbesondere im Bereich der sozialen Vorurteile. Eine aktuelle Studie zeigt, dass große Sprachmodelle ähnliche Vorurteile wie Menschen aufweisen können. Diese Erkenntnisse werfen wichtige Fragen zur Verantwortung und Ethik in der KI-Entwicklung auf.

Die Künstliche Intelligenz hat in den letzten Jahren enorme Fortschritte gemacht, insbesondere im Bereich der Sprachverarbeitung. Doch mit diesen Fortschritten kommen auch neue Herausforderungen. Eine aktuelle Studie von Wissenschaftlern der New York University und der University of Cambridge hat gezeigt, dass große Sprachmodelle, ähnlich wie Menschen, soziale Vorurteile aufweisen können. Diese Vorurteile manifestieren sich in Form von ‘Ingroup’-Favoritismus und ‘Outgroup’-Feindseligkeit, was bedeutet, dass die Modelle dazu neigen, Gruppen, denen sie zugeordnet werden, positiv darzustellen, während sie andere Gruppen negativ bewerten.

Diese Erkenntnisse sind nicht nur theoretischer Natur, sondern haben auch praktische Implikationen für die Art und Weise, wie KI-Systeme entwickelt und eingesetzt werden. Die Forscher verwendeten verschiedene Sprachmodelle, darunter auch fortgeschrittene Modelle wie GPT-4, um Sätze mit den Eingaben ‘Wir sind’ und ‘Sie sind’ zu generieren. Die Ergebnisse waren eindeutig: Sätze, die mit ‘Wir sind’ begannen, waren signifikant positiver als solche, die mit ‘Sie sind’ begannen, was auf eine tief verwurzelte Tendenz zur Gruppenbildung hinweist.

Die Auswirkungen dieser Vorurteile sind weitreichend. In einer zunehmend digitalisierten Welt, in der KI-Systeme in vielen Bereichen des täglichen Lebens integriert sind, könnten solche Vorurteile bestehende soziale Spaltungen verstärken. Daher ist es von entscheidender Bedeutung, dass Entwickler und Forscher Wege finden, diese Vorurteile zu minimieren. Eine Möglichkeit, dies zu erreichen, besteht in der sorgfältigen Auswahl und Kuratierung der Trainingsdaten, wie die Studie zeigt. Durch das Filtern von polarisierenden Inhalten konnten die Forscher die Vorurteile in den Modellen signifikant reduzieren.

Die Studie hebt auch hervor, dass die Reduzierung von ‘Ingroup’-Solidarität in den Trainingsdaten auch die ‘Outgroup’-Feindseligkeit verringern kann. Dies unterstreicht die Rolle, die die Wahrnehmung der eigenen Gruppe bei der Diskriminierung anderer spielt. Diese Erkenntnisse bieten einen vielversprechenden Ansatz zur Verbesserung der KI-Entwicklung und -Schulung, indem sie zeigen, dass selbst relativ einfache Datenkurationsstrategien erhebliche Auswirkungen auf das Verhalten von Modellen haben können.

Die Forscher betonen die Notwendigkeit, die Interaktionen zwischen Menschen und KI-Systemen besser zu verstehen, um zu verhindern, dass bestehende soziale Vorurteile verstärkt werden. Dies ist besonders wichtig, da KI-Systeme zunehmend in Bereichen wie Kundenservice, Gesundheitswesen und Bildung eingesetzt werden, wo sie direkten Einfluss auf das Leben der Menschen haben können.

Insgesamt zeigt die Studie, dass die Entwicklung von KI-Systemen nicht nur eine technische, sondern auch eine ethische Herausforderung darstellt. Entwickler und Forscher müssen sicherstellen, dass die von ihnen entwickelten Systeme nicht nur effizient, sondern auch fair und unvoreingenommen sind. Dies erfordert eine enge Zusammenarbeit zwischen Technikern, Sozialwissenschaftlern und Ethikern, um sicherzustellen, dass KI-Systeme zum Wohl der Gesellschaft eingesetzt werden.

- Die besten Bücher rund um KI & Robotik!

- Die besten KI-News kostenlos per eMail erhalten!

- Zur Startseite von IT BOLTWISE® für aktuelle KI-News!

- Service Directory für AI Adult Services erkunden!

- IT BOLTWISE® kostenlos auf Patreon unterstützen!

- Aktuelle KI-Jobs auf StepStone finden und bewerben!

Stellenangebote

Senior Consultant AI Governance, Compliance & Risk (m/w/d)

AI Engineer w/m/d

Vorausentwickler Signalverarbeitung Sonar-System: Künstliche Intelligenz - Maschinelles Lernen (m/w/d)

Abschlussarbeit (Bachelor / Master) im Bereich Einkauf: Einsatz von Künstlicher Intelligenz

- Die Zukunft von Mensch und MaschineIm neuen Buch des renommierten Zukunftsforschers und Technologie-Visionärs Ray Kurzweil wird eine faszinierende Vision der kommenden Jahre und Jahrzehnte entworfen – eine Welt, die von KI durchdrungen sein wird

- Künstliche Intelligenz: Expertenwissen gegen Hysterie Der renommierte Gehirnforscher, Psychiater und Bestseller-Autor Manfred Spitzer ist ein ausgewiesener Experte für neuronale Netze, auf denen KI aufbaut

- Obwohl Künstliche Intelligenz (KI) derzeit in aller Munde ist, setzen bislang nur wenige Unternehmen die Technologie wirklich erfolgreich ein

- Wie funktioniert Künstliche Intelligenz (KI) und gibt es Parallelen zum menschlichen Gehirn? Was sind die Gemeinsamkeiten von natürlicher und künstlicher Intelligenz, und was die Unterschiede? Ist das Gehirn nichts anderes als ein biologischer Computer? Was sind Neuronale Netze und wie kann der Begriff Deep Learning einfach erklärt werden?Seit der kognitiven Revolution Mitte des letzten Jahrhunderts sind KI und Hirnforschung eng miteinander verflochten

Du hast einen wertvollen Beitrag oder Kommentar zum Artikel "KI-Modelle spiegeln menschliche Vorurteile wider: Herausforderungen und Lösungen" für unsere Leser?

#Sophos

#Sophos

Es werden alle Kommentare moderiert!

Für eine offene Diskussion behalten wir uns vor, jeden Kommentar zu löschen, der nicht direkt auf das Thema abzielt oder nur den Zweck hat, Leser oder Autoren herabzuwürdigen.

Wir möchten, dass respektvoll miteinander kommuniziert wird, so als ob die Diskussion mit real anwesenden Personen geführt wird. Dies machen wir für den Großteil unserer Leser, der sachlich und konstruktiv über ein Thema sprechen möchte.

Du willst nichts verpassen?

Du möchtest über ähnliche News und Beiträge wie "KI-Modelle spiegeln menschliche Vorurteile wider: Herausforderungen und Lösungen" informiert werden? Neben der E-Mail-Benachrichtigung habt ihr auch die Möglichkeit, den Feed dieses Beitrags zu abonnieren. Wer natürlich alles lesen möchte, der sollte den RSS-Hauptfeed oder IT BOLTWISE® bei Google News wie auch bei Bing News abonnieren.

Nutze die Google-Suchmaschine für eine weitere Themenrecherche: »KI-Modelle spiegeln menschliche Vorurteile wider: Herausforderungen und Lösungen« bei Google Deutschland suchen, bei Bing oder Google News!