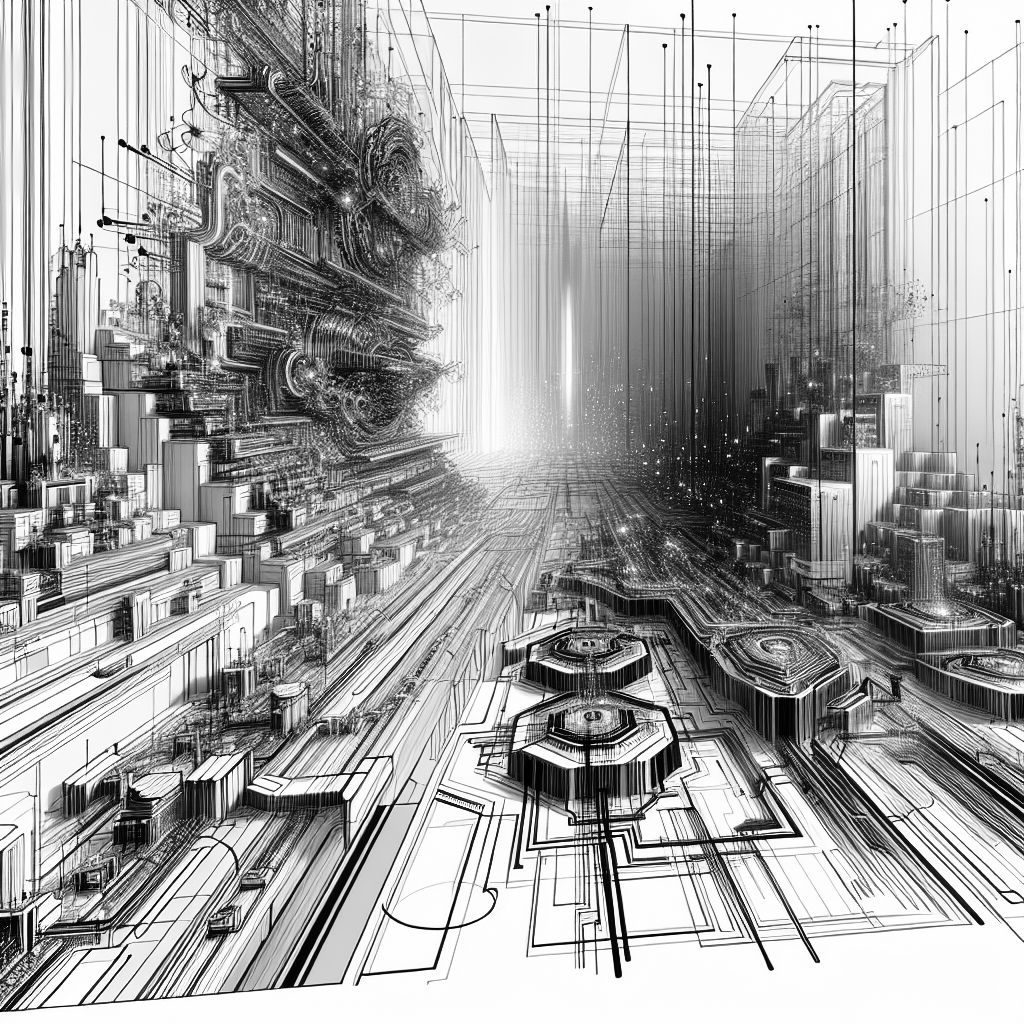

MÜNCHEN (IT BOLTWISE) – Die Welt der Künstlichen Intelligenz hat in den letzten Jahren bemerkenswerte Fortschritte gemacht, insbesondere durch die Entwicklung von Large Language Models (LLMs). Diese Modelle, darunter bekannte Namen wie GPT-4 und LLaMA, haben die Art und Weise, wie wir mit Maschinen interagieren, revolutioniert. Doch was steckt hinter diesen mächtigen Werkzeugen, die in der Lage sind, menschliche Sprache zu verstehen und zu generieren?

Die Entwicklung von Large Language Models (LLMs) hat die Landschaft der Künstlichen Intelligenz nachhaltig verändert. Diese Modelle sind darauf ausgelegt, menschliche Sprache zu verarbeiten und zu generieren, indem sie tiefschichtige neuronale Netze nutzen, um Muster und Beziehungen innerhalb von Sprachdaten zu lernen. Ein zentraler Bestandteil dieser Modelle ist die Transformer-Architektur, die 2017 mit dem bahnbrechenden Paper „Attention Is All You Need“ eingeführt wurde. Im Gegensatz zu früheren Ansätzen wie RNNs oder CNNs ermöglicht der Transformer durch Self-Attention-Mechanismen, Kontextbeziehungen zwischen allen Wörtern in einem Text parallel zu erfassen.

Ein LLM besteht aus mehreren Schlüsselkomponenten, darunter der Tokenizer, der Eingabetexte in kleinere Einheiten, sogenannte Tokens, zerlegt. Diese Tokens können Wörter, Subwörter oder sogar einzelne Zeichen sein. Die Embeddings-Schicht wandelt diese Tokens in numerische Darstellungen um, die das Modell verstehen kann. Diese Embeddings erfassen die semantische Bedeutung der Tokens, sodass das Modell zwischen Wörtern mit ähnlichen Bedeutungen unterscheiden kann.

Der Encoder des Modells generiert eine kontinuierliche Darstellung des Eingabetextes, die als „kontextualisierte Darstellung“ bezeichnet wird. Diese Darstellung erfasst die Nuancen der Sprache, wie Syntax, Semantik und Kontext. Der Decoder hingegen ist für die Textgenerierung verantwortlich und verhält sich wie ein hochentwickelter Sprachgenerator, der kohärente und kontextuell relevante Texte produzieren kann.

Ein weiteres zentrales Element der LLMs ist der Self-Attention-Mechanismus, der es dem Modell ermöglicht, auf verschiedene Teile des Eingabetextes zu achten und eine kontextualisierte Darstellung zu generieren. Multi-Head-Attention erweitert diesen Ansatz, indem es dem Modell ermöglicht, auf verschiedene Teile des Textes gleichzeitig aus unterschiedlichen Perspektiven zu achten. Dies führt zu einer diversifizierten Erfassung von Kontextabhängigkeiten.

Die Anwendung von LLMs ist vielfältig und reicht von der automatisierten Textgenerierung bis hin zur Unterstützung bei der Analyse komplexer Datenmuster. Unternehmen nutzen diese Modelle, um ihre Geschäftsprozesse zu optimieren und neue Möglichkeiten der Interaktion mit Kunden zu schaffen. Die Herausforderungen liegen jedoch in den hohen Hardwareanforderungen und der Notwendigkeit, große Mengen an Trainingsdaten zu verarbeiten.

In der Zukunft könnten LLMs noch weiter in den Alltag integriert werden, indem sie in personalisierten Assistenzsystemen oder in der Echtzeit-Übersetzung von Sprachen eingesetzt werden. Die kontinuierliche Weiterentwicklung dieser Modelle verspricht, die Art und Weise, wie wir mit Technologie interagieren, weiter zu transformieren.

- Die besten Bücher rund um KI & Robotik!

- Die besten KI-News kostenlos per eMail erhalten!

- Zur Startseite von IT BOLTWISE® für aktuelle KI-News!

- Service Directory für AI Adult Services erkunden!

- IT BOLTWISE® kostenlos auf Patreon unterstützen!

- Aktuelle KI-Jobs auf StepStone finden und bewerben!

Stellenangebote

Chef de Rang (m/w/d) für unser italienisches Restaurant Ai Pero

Senior Solution Customer Success Manager (f/m/d) for SAP Business AI

Vorausentwickler Signalverarbeitung Sonar-System: Künstliche Intelligenz - Maschinelles Lernen (m/w/d)

Data Scientist (m/w/d) Schwerpunkt KI

- Die Zukunft von Mensch und MaschineIm neuen Buch des renommierten Zukunftsforschers und Technologie-Visionärs Ray Kurzweil wird eine faszinierende Vision der kommenden Jahre und Jahrzehnte entworfen – eine Welt, die von KI durchdrungen sein wird

- Künstliche Intelligenz: Expertenwissen gegen Hysterie Der renommierte Gehirnforscher, Psychiater und Bestseller-Autor Manfred Spitzer ist ein ausgewiesener Experte für neuronale Netze, auf denen KI aufbaut

- Obwohl Künstliche Intelligenz (KI) derzeit in aller Munde ist, setzen bislang nur wenige Unternehmen die Technologie wirklich erfolgreich ein

- Wie funktioniert Künstliche Intelligenz (KI) und gibt es Parallelen zum menschlichen Gehirn? Was sind die Gemeinsamkeiten von natürlicher und künstlicher Intelligenz, und was die Unterschiede? Ist das Gehirn nichts anderes als ein biologischer Computer? Was sind Neuronale Netze und wie kann der Begriff Deep Learning einfach erklärt werden?Seit der kognitiven Revolution Mitte des letzten Jahrhunderts sind KI und Hirnforschung eng miteinander verflochten

Du hast einen wertvollen Beitrag oder Kommentar zum Artikel "Die faszinierende Welt der Large Language Models: Ein Einblick in die Mechanismen" für unsere Leser?

#Sophos

#Sophos

Es werden alle Kommentare moderiert!

Für eine offene Diskussion behalten wir uns vor, jeden Kommentar zu löschen, der nicht direkt auf das Thema abzielt oder nur den Zweck hat, Leser oder Autoren herabzuwürdigen.

Wir möchten, dass respektvoll miteinander kommuniziert wird, so als ob die Diskussion mit real anwesenden Personen geführt wird. Dies machen wir für den Großteil unserer Leser, der sachlich und konstruktiv über ein Thema sprechen möchte.

Du willst nichts verpassen?

Du möchtest über ähnliche News und Beiträge wie "Die faszinierende Welt der Large Language Models: Ein Einblick in die Mechanismen" informiert werden? Neben der E-Mail-Benachrichtigung habt ihr auch die Möglichkeit, den Feed dieses Beitrags zu abonnieren. Wer natürlich alles lesen möchte, der sollte den RSS-Hauptfeed oder IT BOLTWISE® bei Google News wie auch bei Bing News abonnieren.

Nutze die Google-Suchmaschine für eine weitere Themenrecherche: »Die faszinierende Welt der Large Language Models: Ein Einblick in die Mechanismen« bei Google Deutschland suchen, bei Bing oder Google News!